데이터베이스 동기화, 더 나은 방법은 없을까요?

마이크로서비스, 캐시, 검색 인덱스 등 다양한 시스템을 주 데이터베이스와 동기화하는 것은 많은 개발팀이 마주하는 흔하고도 골치 아픈 문제입니다. 이 문제를 해결하기 위해 많은 팀이 '듀얼 라이트(dual writes)'나 '폴링(polling)'과 같은 전통적인 방식을 사용합니다. 하지만 이 방법들은 근본적인 결함을 가지고 있습니다.

듀얼 라이트는 애플리케이션이 데이터베이스에 쓸 때마다 다른 시스템(예: 검색 인덱스)에도 동시에 데이터를 쓰는 방식입니다. 하지만 두 시스템이 하나의 글로벌 트랜잭션으로 묶여 있지 않기 때문에, 한쪽 쓰기가 실패하면 데이터 불일치가 발생하고 복잡한 경쟁 조건(race condition)에 빠지기 쉽습니다. 반면 폴링은 주기적으로 데이터베이스에 "변경된 것이 있나요?"라고 묻는 방식입니다. 이 방법은 데이터베이스에 엄청난 부하를 줄 뿐만 아니라, 레코드가 삭제되었을 때 그 사실을 안정적으로 알아낼 방법이 없다는 치명적인 단점이 있습니다.

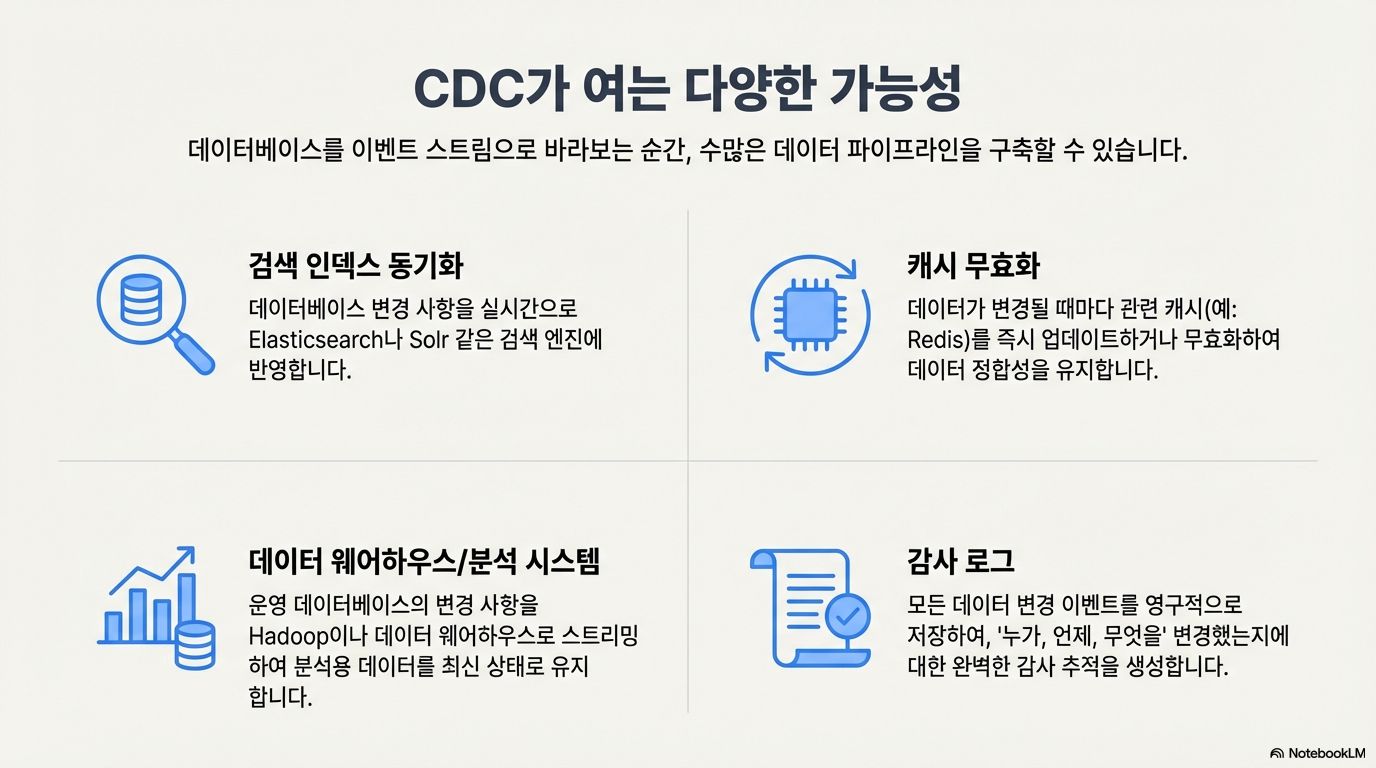

여기서 '변경 데이터 캡처(Change Data Capture, CDC)'가 등장합니다. CDC는 데이터베이스를 단순히 수동적인 데이터 저장소로 보지 않고, 실시간 이벤트 스트림의 원천으로 바라보는 패러다임의 전환을 제시합니다. CDC를 활용하면 캐시 무효화, 검색 인덱스 동기화, 감사 로그 생성 등 다양한 작업을 우아하게 처리할 수 있습니다. 이 글에서는 CDC 기술이 단순한 데이터 복제를 넘어, 얼마나 놀랍고 강력한 방식으로 활용될 수 있는지 5가지 구체적인 사례를 통해 알아보겠습니다.

1. 데이터베이스에 "묻지 말고" 그냥 "들으세요": 트랜잭션 로그의 힘

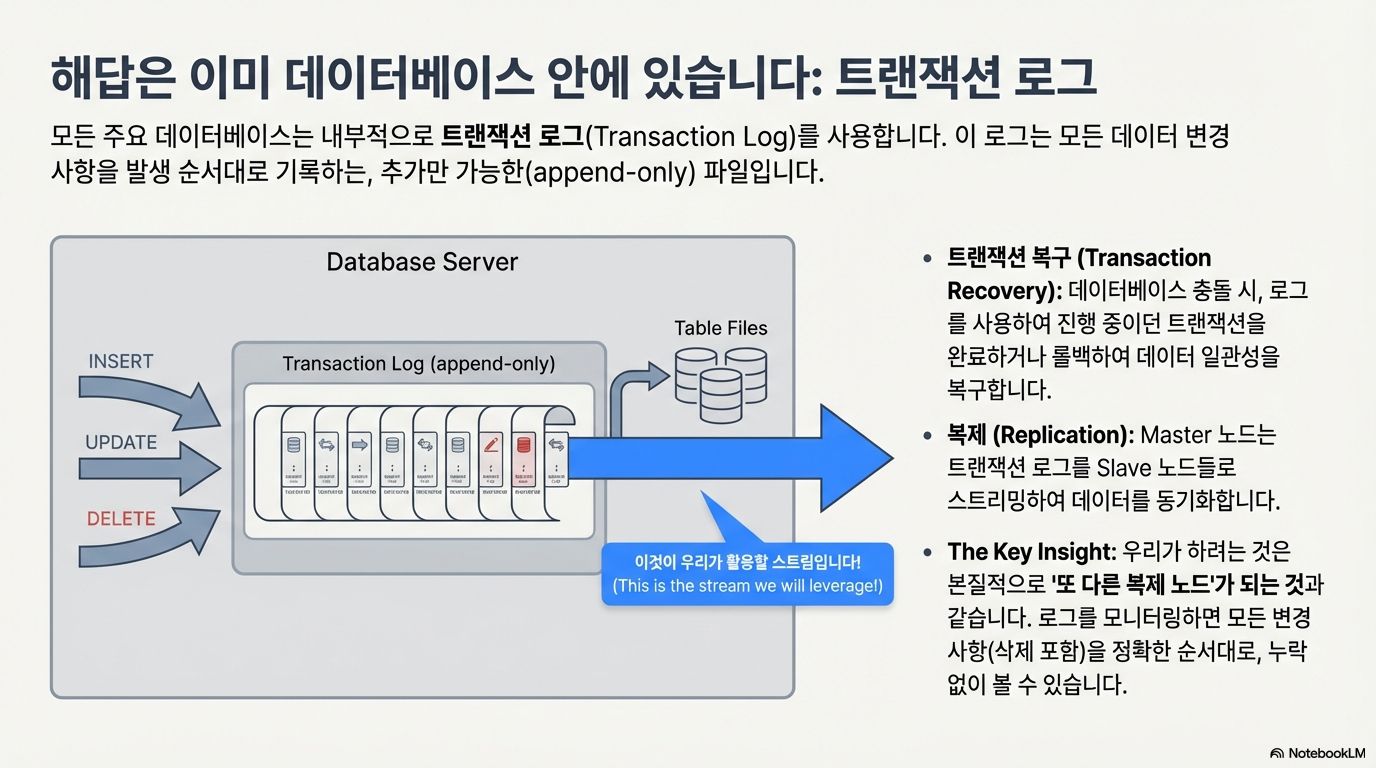

CDC의 핵심은 데이터베이스와 상호작용하는 방식을 근본적으로 바꾸는 데 있습니다. 기존의 폴링 방식이 계속해서 데이터베이스에 변경 사항을 '물어보는' 풀(pull) 모델이었다면, 로그 기반 CDC는 데이터베이스의 트랜잭션 로그에서 발생하는 이벤트 스트림을 수동적으로 '듣는' 푸시(push) 모델입니다.

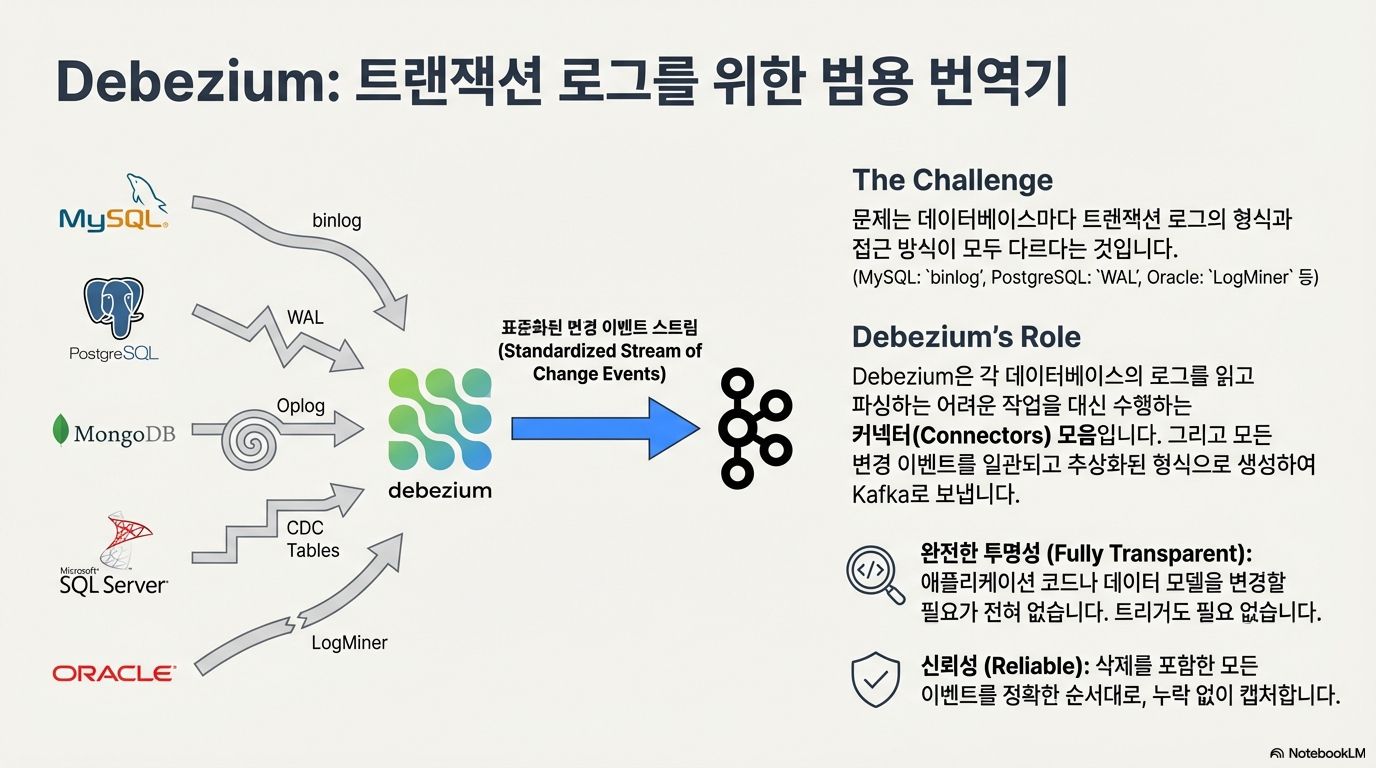

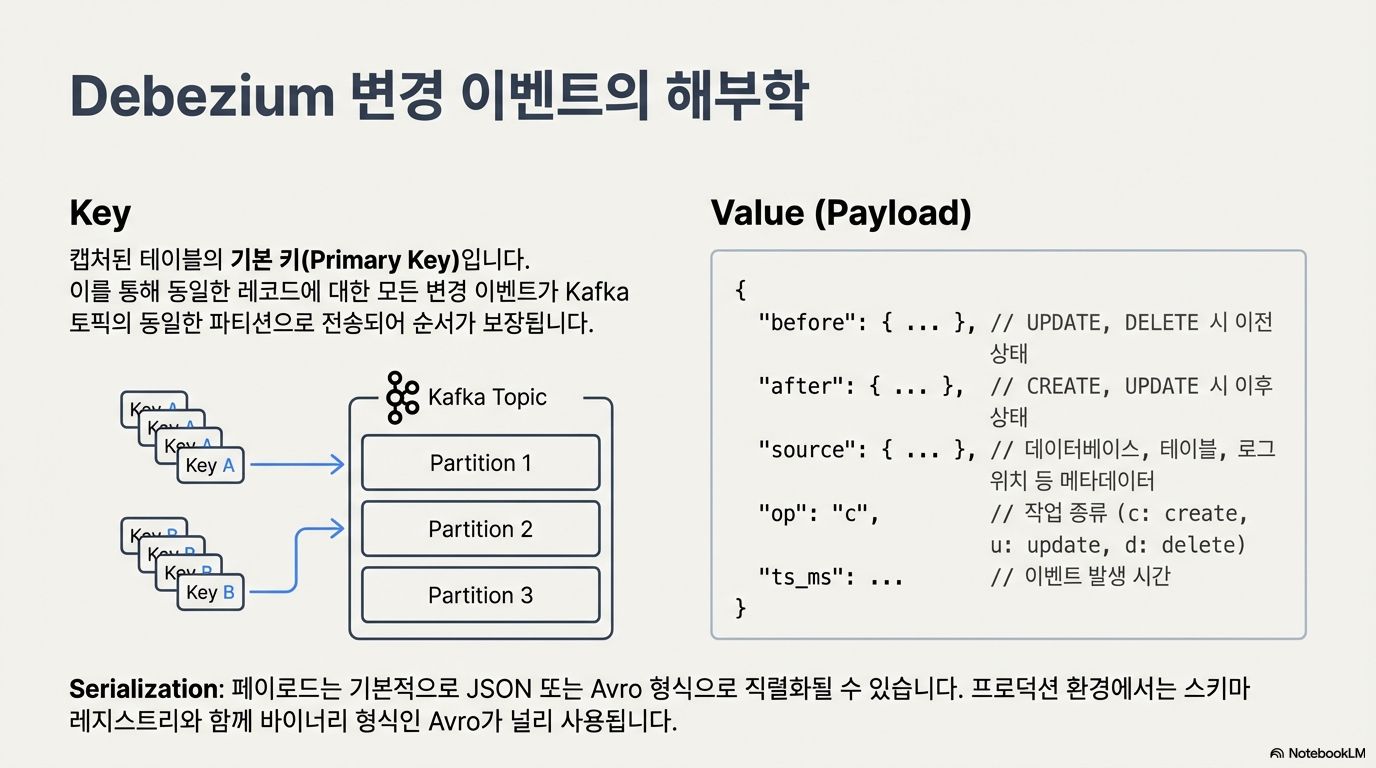

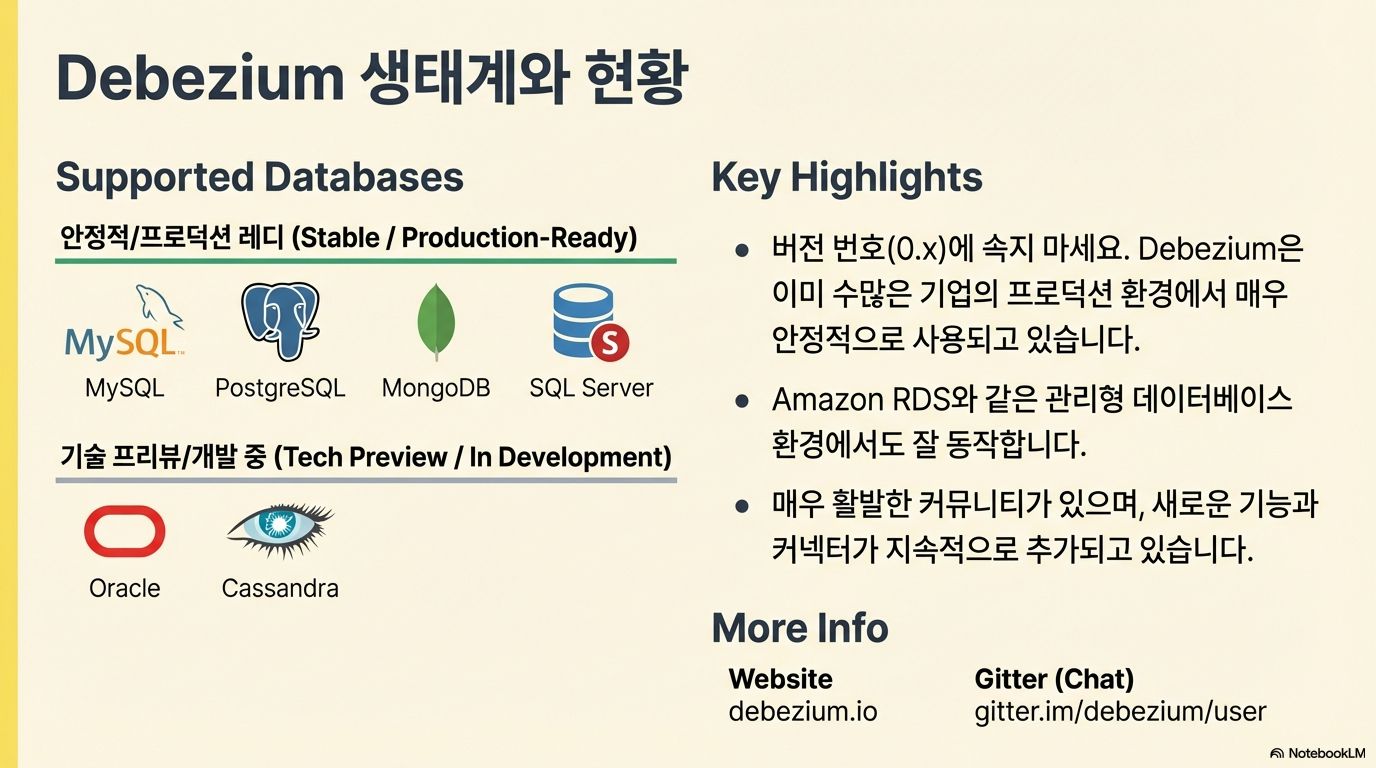

MySQL의 바이너리 로그(binlog)나 Postgres의 WAL(Write-Ahead Log)과 같은 데이터베이스는 이미 내부적으로 데이터 복구나 복제 목적으로 모든 변경 사항(INSERT, UPDATE, DELETE)을 트랜잭션 로그에 순서대로 기록하고 있습니다. Debezium과 같은 CDC 도구는 바로 이 메커니즘을 활용합니다. 애플리케이션을 수정할 필요 없이, 데이터베이스의 로그를 읽어 변경 사항을 이벤트로 만들어내는 것입니다.

이 방식이 제공하는 핵심 이점은 다음과 같습니다.

- 완전한 투명성 (Full transparency): 기존 애플리케이션의 코드를 단 한 줄도 변경할 필요가 없습니다.

- 모든 변경 사항 캡처 (Captures all changes): INSERT, UPDATE는 물론, 폴링 방식으로는 감지하기 어려운 DELETE 이벤트까지 안정적으로 캡처합니다.

- 정확한 순서 보장 (Guaranteed order): 이벤트는 데이터베이스에 커밋된 순서와 정확히 동일한 순서로 캡처됩니다.

"우리는 본질적으로 데이터베이스의 또 다른 복제 노드가 되는 것과 같은 일을 하려는 것입니다."

2. 마이크로서비스 아키텍처의 함정, '분산 모놀리스'를 피하는 법

마이크로서비스 아키텍처에서 서비스 간 데이터 동기화는 매우 중요한 과제입니다. 예를 들어, 주문을 처리하는 'Order' 서비스가 상품 정보를 가진 'Item' 서비스와 재고 정보를 가진 'Stock' 서비스의 데이터가 필요하다고 가정해 봅시다.

가장 흔한 접근 방식은 'Order' 서비스가 REST API 등을 통해 다른 서비스들을 직접 동기적으로 호출하는 것입니다. 하지만 이 방식은 서비스 간의 강한 결합(tight coupling)을 만들어냅니다. 만약 'Stock' 서비스에 장애가 발생하면 'Order' 서비스까지 연쇄적으로 영향을 받는, 소위 '분산 모놀리스(distributed monolith)'라는 취약한 구조가 되어버립니다.

CDC는 이 문제를 우아하게 해결합니다. 'Order' 서비스는 'Item' 및 'Stock' 데이터베이스의 변경 데이터 스트림을 구독합니다. 그리고 이 스트림을 기반으로 'Order' 서비스 내부에 필요한 데이터만 가진 자체적인 로컬 데이터 뷰(materialized view)를 유지합니다. 이 비동기적인 접근 방식은 각 서비스의 자율성과 회복탄력성을 극적으로 높여줍니다. 물론 데이터가 약간의 지연을 가질 수 있는 최종적 일관성(eventual consistency) 모델이지만, 대부분의 비즈니스 시나리오에서 이는 충분히 수용 가능한 트레이드오프입니다. 한번 생각해보면, 우리는 어차피 이런 상황에 대처할 준비가 되어 있어야 합니다. 가령 창고에서 상품 10개가 파손되었다고 상상해보세요. 이 사건은 데이터베이스 트랜잭션 안에서 즉시 반영되지 않습니다.

"현실은 사실 트랜잭션적이지 않습니다."

3. 거대한 모놀리스 애플리케이션을 안전하게 분해하는 전략

기존의 거대한 모놀리스 애플리케이션을 마이크로서비스로 전환하는 작업은 매우 위험하고 복잡합니다. CDC는 이 거대한 전환 과정을 안전하고 점진적으로 수행할 수 있는 강력한 전략을 제공합니다.

전체 프로세스는 다음과 같습니다.

- 먼저, 모놀리스에서 분리할 컴포넌트를 식별합니다 (예: 'Stock' 컴포넌트).

- 기존 모놀리스는 프로덕션에서 계속 운영하면서, 옆에서 새로운 'Stock' 마이크로서비스를 개발합니다.

- Debezium을 사용해 모놀리스 데이터베이스에서 발생하는 모든 'Stock' 관련 데이터 변경 사항을 새로운 마이크로서비스의 데이터베이스로 실시간 스트리밍합니다.

- 이를 통해 새로운 서비스는 실제 프로덕션 데이터 패턴과 똑같은 데이터로 동기화되며, 사용자에게 영향을 주지 않으면서 충분한 테스트와 검증을 수행할 수 있습니다.

- 새로운 서비스가 안정적으로 동작한다는 확신이 들면, 트래픽을 새로운 마이크로서비스로 전환합니다.

이 패턴은 모든 것을 한 번에 바꾸는 '빅뱅' 방식의 위험을 제거하고, 안전하며 예측 가능한 현대화 경로를 제공합니다.

4. 데이터베이스를 실시간 분석 엔진으로 변신시키기

CDC의 가장 역동적인 활용 사례 중 하나는 '스트리밍 쿼리'를 통한 실시간 분석입니다. "지난 한 시간 동안 카테고리별 총매출은 얼마인가?"와 같은 비즈니스 통찰력을 얻기 위해 주기적으로 배치 쿼리를 실행하는 대신, 데이터가 변경되는 바로 그 순간에 실시간으로 지표를 계산할 수 있습니다.

데모에서 소개된 시나리오는 다음과 같습니다.

- Debezium이 MySQL 데이터베이스의 'orders' 테이블에서 발생하는 변경 사항을 Kafka 토픽으로 스트리밍합니다.

- Quarkus 기반으로 구축된 Kafka Streams 애플리케이션이 이 토픽을 구독합니다.

- 이 애플리케이션은 5초의 시간 창(window) 내에서 카테고리별 총 주문 금액을 지속적으로 집계하는 실시간 연산을 수행합니다.

- 결과는 실시간으로 **웹소켓(WebSockets)**을 통해 라이브 대시보드로 직접 전송됩니다.

이 접근 방식은 분석을 과거 데이터를 살펴보는 사후 대응적 활동에서, 현재 일어나는 일을 즉시 파악하고 대응하는 사전 예방적 활동으로 완전히 탈바꿈시킵니다.

5. 데이터 파이프라인의 숨은 조력자, SMT(Single Message Transforms) 활용하기

데이터 파이프라인을 구축하다 보면 종종 이벤트 메시지의 구조를 변경하거나 특정 조건에 따라 라우팅해야 할 필요가 생깁니다. Kafka Connect의 SMT(Single Message Transforms)는 이러한 요구사항을 별도의 코딩 없이 해결해 주는 강력하고 실용적인 기능입니다.

SMT는 데이터 파이프라인을 통과하는 개별 이벤트 레코드를 수정하거나 경로를 재지정할 수 있는 작은 플러그인 컴포넌트입니다. 설정만으로 다양한 데이터 변환 작업을 수행할 수 있습니다. 주요 활용 사례는 다음과 같습니다.

- 라우팅 (Routing): 여러 테이블에서 발생한 변경 이벤트를 단일 Kafka 토픽으로 통합할 수 있습니다.

- 구조 변경 (Structure Alteration): Debezium의 복잡한 이벤트 구조(before, after, source 등)에서 데이터의 최종 상태인 after 부분만 추출하여 평평한(flat) 레코드로 만듭니다. 이는 Elasticsearch 커넥터와 같이 단순한 레코드 구조를 기대하는 많은 싱크(sink) 시스템과 손쉽게 연동하기 위함입니다.

- 호환성 계층 (Compatibility Layer): 데이터베이스 컬럼 이름이 변경되었을 때, 기존 컨슈머들이 애플리케이션을 수정할 시간을 벌어주기 위해 일시적으로 이전 이름과 새 이름을 모두 포함하는 메시지를 생성하여 하위 호환성을 유지할 수 있습니다.

SMT는 데이터 파이프라인을 유연하게 조정하고 관리할 수 있는 방법을 제공하며, 일반적인 통합 문제를 구성 수준에서 직접 해결할 수 있게 해줍니다.

결론: 당신의 데이터가 말을 걸어올 때

Debezium과 Kafka 같은 도구를 활용한 변경 데이터 캡처(CDC)는 데이터베이스를 수동적인 데이터 저장소에서 비즈니스 가치가 담긴 이벤트를 실시간으로 발생시키는 능동적인 원천으로 근본적으로 변화시킵니다.

이를 통해 우리는 단순한 데이터 복제를 훨씬 뛰어넘어, 회복탄력성 있는 마이크로서비스를 구축하고, 더 안전하게 시스템을 현대화하며, 실시간으로 비즈니스를 분석하는 새로운 가능성을 열 수 있습니다.

만약 당신의 데이터베이스에서 일어나는 모든 변화가 실시간으로 반응할 수 있는 이벤트가 된다면, 어떤 새로운 가능성을 열 수 있을까요?

'IT 개발,관리,연동,자동화' 카테고리의 다른 글

| 문법의 시대에서 의도의 시대로: AI가 소프트웨어를 '살아있는 유기체'로 만드는 법 (0) | 2026.01.15 |

|---|---|

| 챗봇을 넘어 '진짜 내 PC 동료'로, 클로드 코워크(Claude Cowork)의 충격적인 활용법 5가지 (1) | 2026.01.14 |

| 구글 제미나이, 아직도 채팅만 하시나요? 1분 만에 나만의 업무 앱을 만드는 '슈퍼잼' 사용법 (1) | 2026.01.11 |

| OpenAI의 '무료 GPT'를 내 컴퓨터에 직접 설치하고 놀란 5가지 이유 (1) | 2026.01.11 |

| '떳다! 모두의 출고' : 대량 출고 상품의 스마트한 변신 플랫폼 기획 (1) | 2026.01.10 |